转自:量子位

如涉版权请加编辑微信iwish89联系

哲学园鸣谢

栗子 安妮 发自 凹非寺

量子位 出品 | 公众号 QbitAI

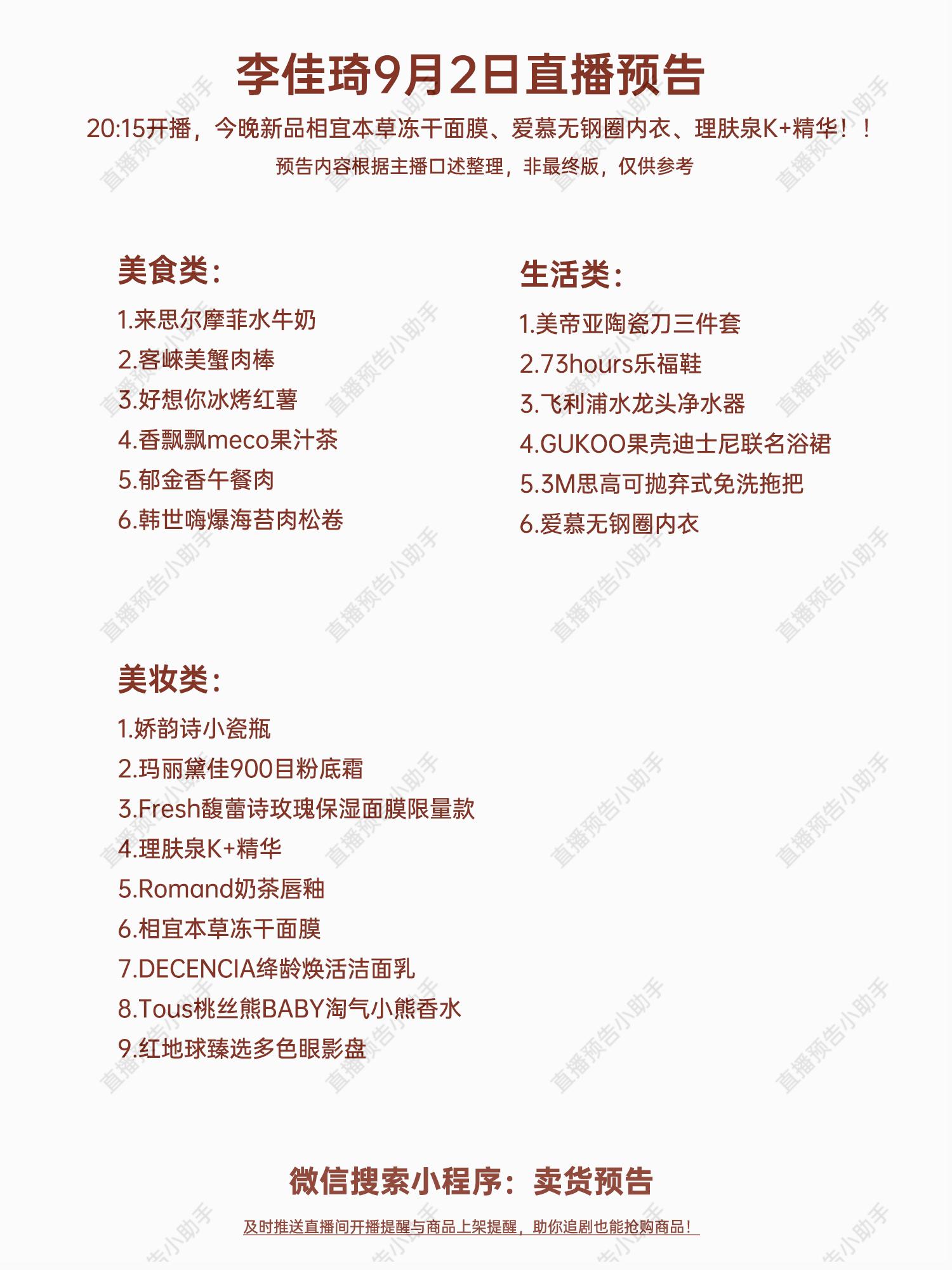

不得了,以生成逼真假照片出名、被称作“史上最佳GAN”的BigGAN,被“本家”踢馆了。

挑战者同样来自Google DeepMind,其新鲜出炉的VQ-VAE二代生成模型,生成出的图像,号称比BigGAN更加高清逼真,而且更具有多样性!

不服气?那先看看这些假照片作品。

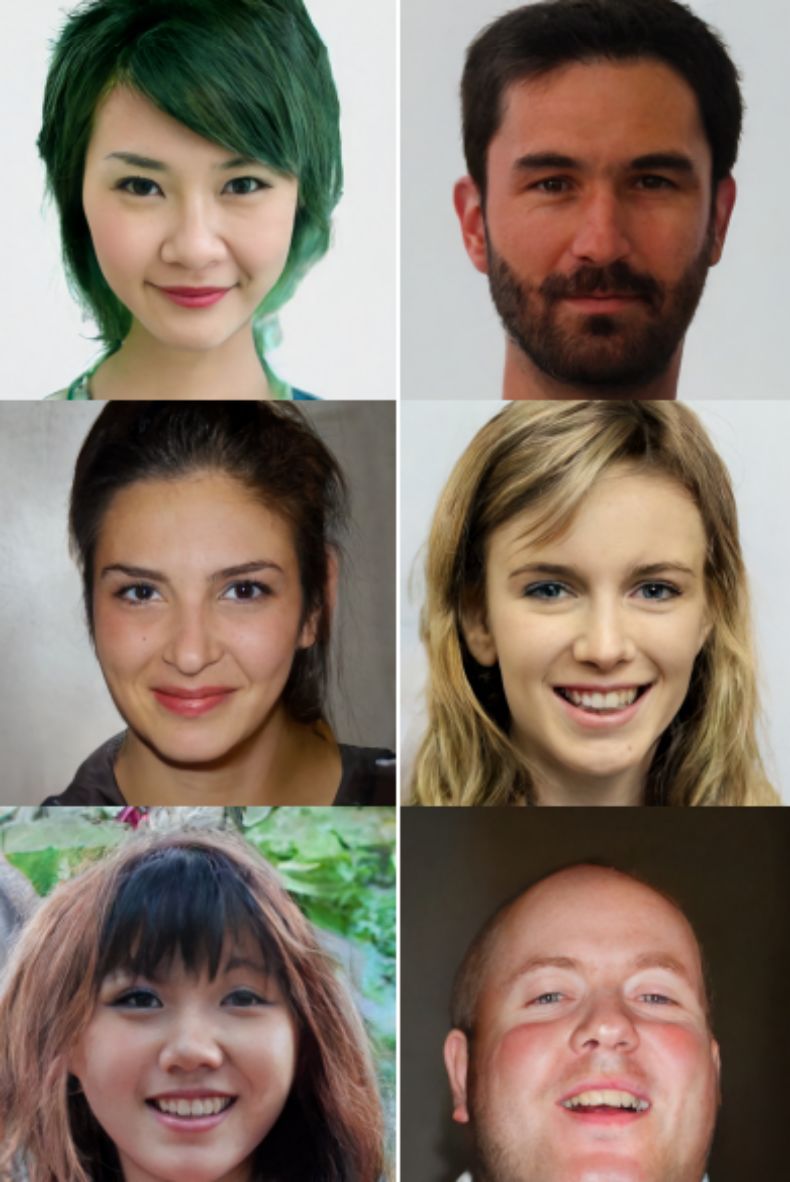

浓眉大眼的棕发妹子,与歪果仁大叔:

神似何洁的亚裔面孔:

胡子清晰可见的短发男:

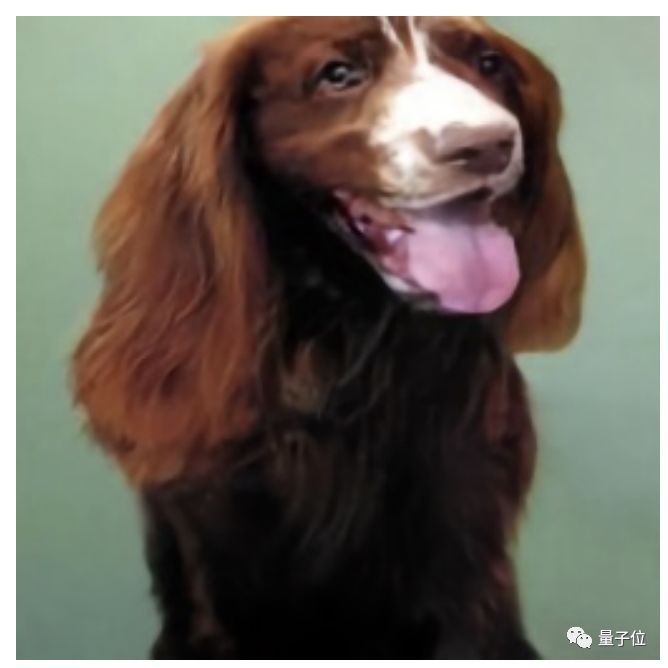

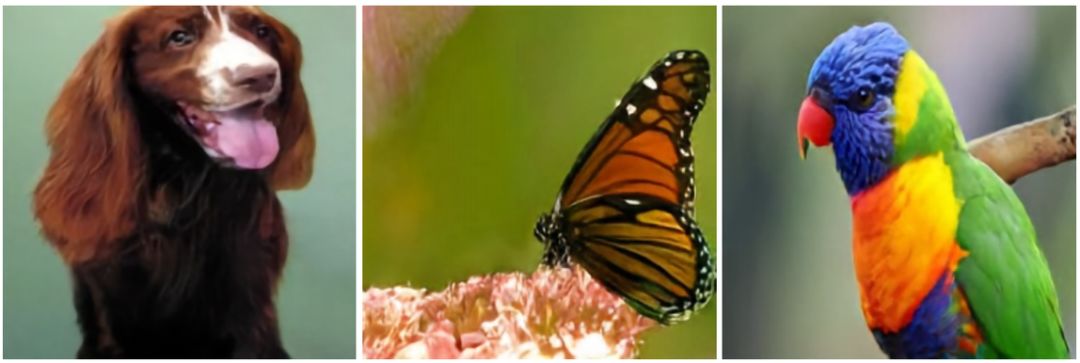

此外,还有各种类型的动物:

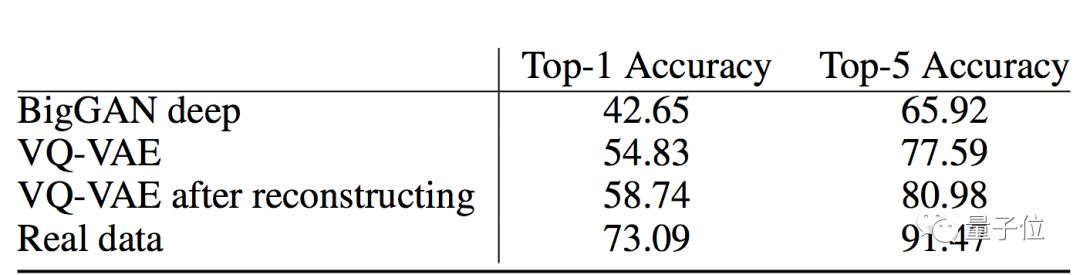

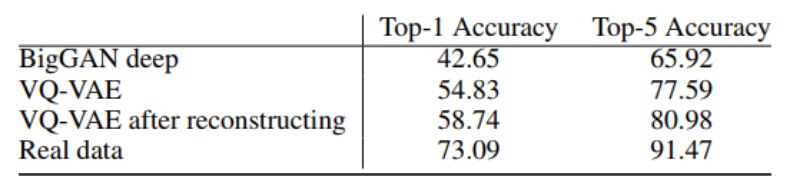

在Top-1准确率测试上,VQ-VAE二代比BigGAN成绩多出了16.09分。

DeepMind负责星际项目、也是这项研究的作者之一Oriol Vinyals表示,VQ-VAE二代简直令人惊讶,如此简单的想法竟然能够产生如此好的生成模型!

甚至……连曾经也推出过逼真假脸的英伟达员工:英伟达研究院的高级研究科学家Arash Vahdat,也在研究推特下评价:

令人印象深刻啊!!!

短短几小时,这项研究在推特上收获了500多赞,以及上百次转发。

来具体看看效果。

真实效果,好到惊艳

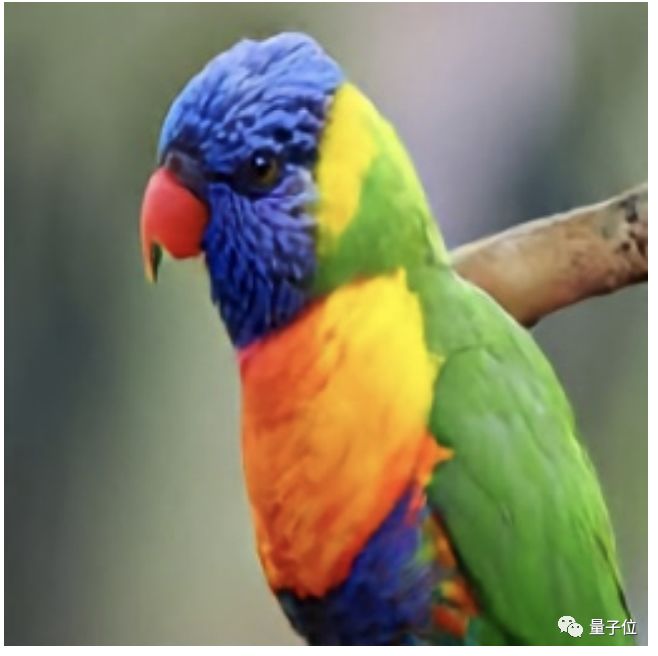

VQ-VAE生成的假照片,可以Hold住多种规格的精确度,在ImageNet上,可以训练出256×256像素的动物:

如果投喂英伟达7万张高清人脸数据集FFHQ(Flickr-Faces-HQ),输出的图像则为1024×1024像素的高清大图,连人脸上的细微毛孔都清晰可见:

这些高清的妹子脸,颜值看起来也不低呢:

VQ-VAE生成出的假照片,比BigGAN的作品多样多了。

与BigGAN相比,VQ-VAE不仅能生成不同物体和动物,还能生成不同视角以及不同姿势的版本。

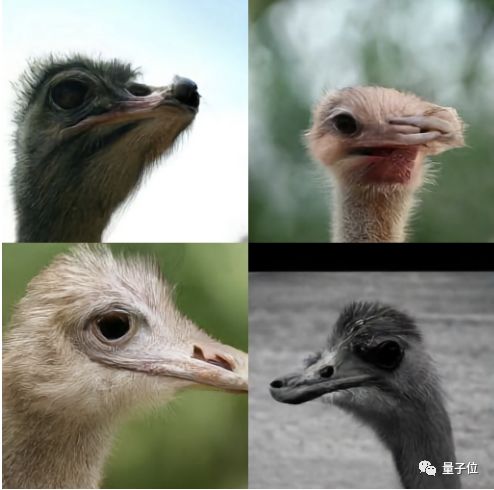

比如,同样是生成鸵鸟,这是VQ-VAE的作品:

而VQ-VAE,光鸵鸟头就能生成不同姿态,有正脸的、侧对镜头的、45度角抬头仰望天空的、以及不想露脸上镜的:

甚至相对简单没有四肢的金鱼,都能合成这么多形态:

而BigGAN的角度相对来说非常单一:

除了肉眼可见的视觉对比,研究人员还做了一票实验,用多个性能指标证明VQ-VAE二代在多维度上优于BigGAN。

从分类准确率得分(Classification Accuracy Score,CAS)上看,VQ-VAE在Top-1准确率上为58.74分,超出了BigGAN 42.65的成绩16.09分,在Top-5准确率上,VQ-VAE领先了15.06分。

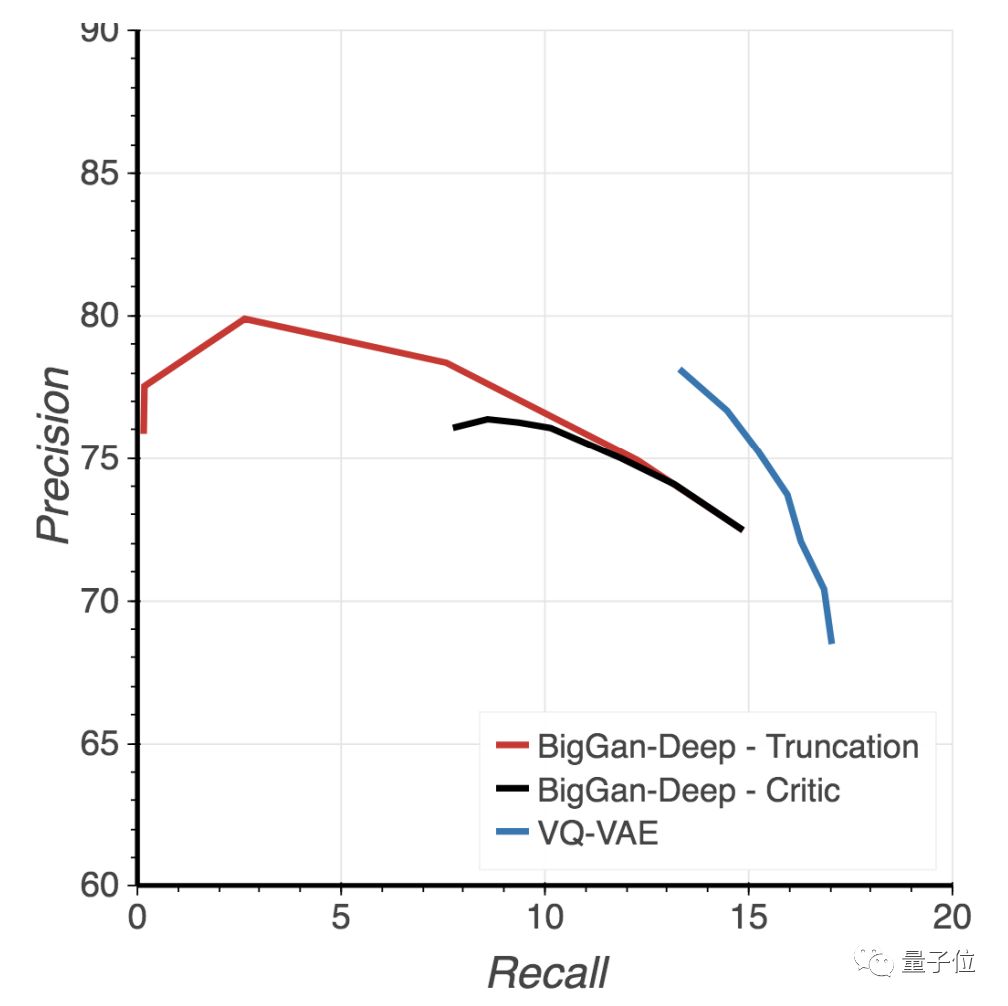

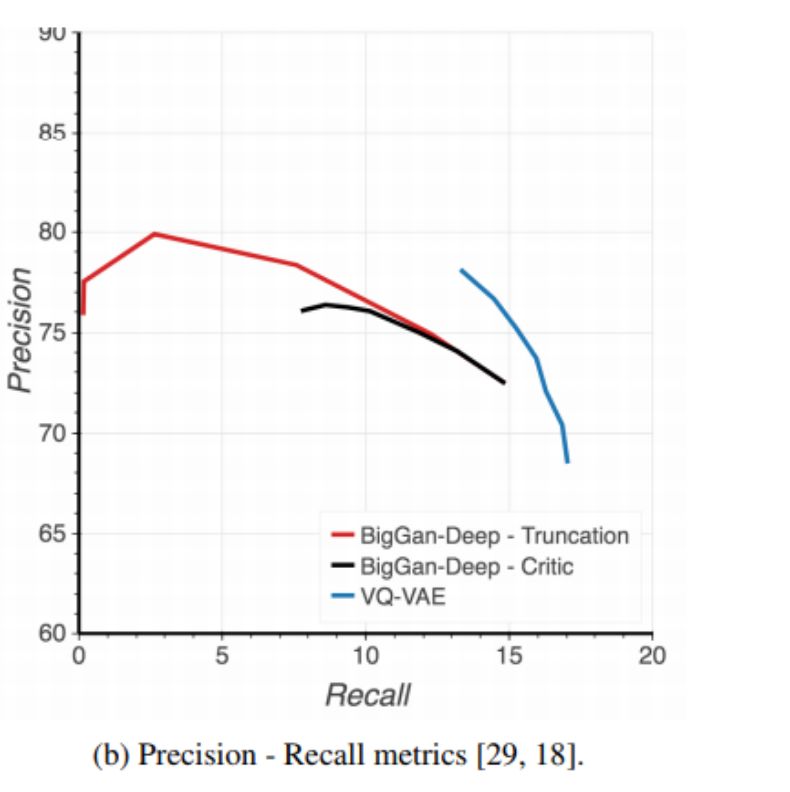

在精确率-召回率指标(Precision - Recall metrics)上,VQ-VAE的精度比BigGAN 稍低,但召回值高出了一大截。

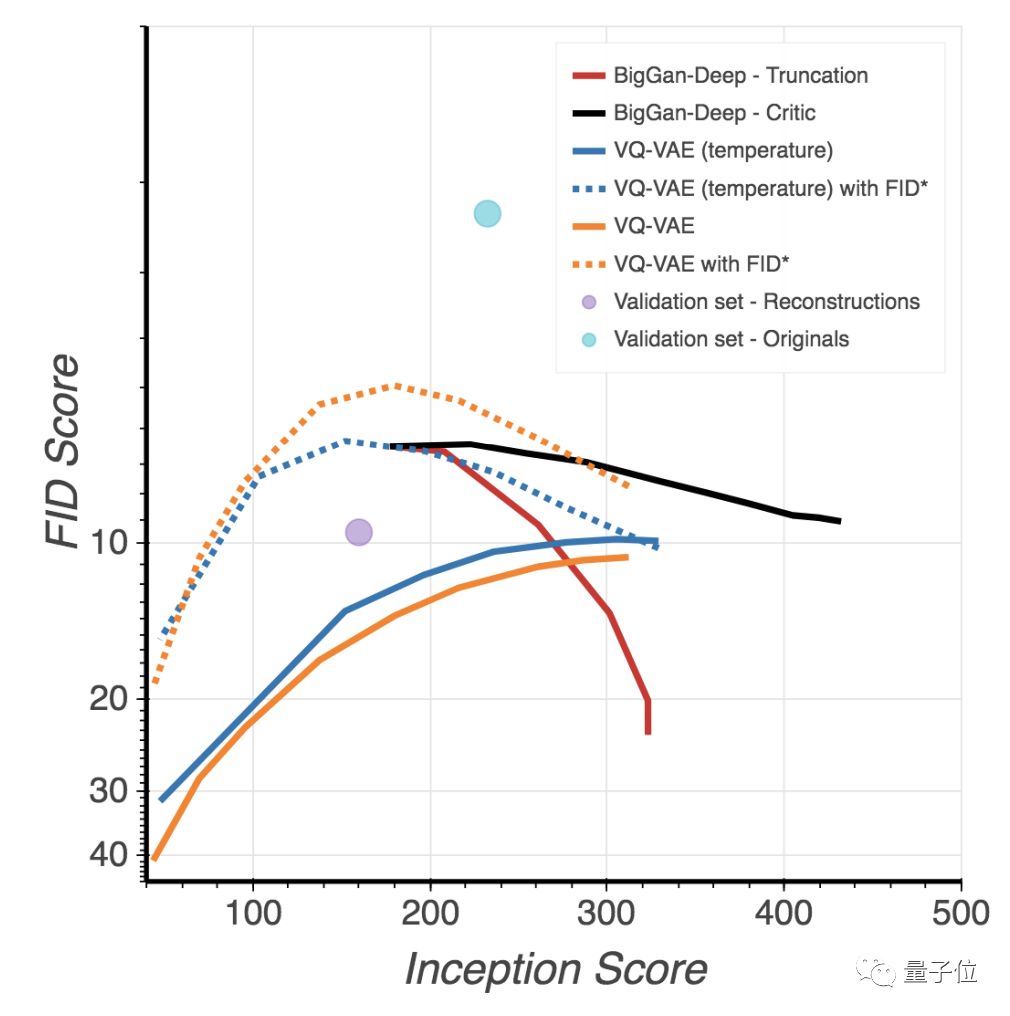

在Inception Scores(IS)上,VQ-VAE没有超越领先前人100多分BigGAN的成绩,但FID值较低。

总体来说,VQ-VAE的表现,在多样性和视觉感官上,已经超越了BigGAN,在各项性能指标上表现也还不错。

弥补了GAN的缺点

VQ-VAE-2可以理解成一个通信系统。

其中有编码器,把观察到的信息映射到一组离散的潜变量 (Latent Variables) 上。

还有解码器,把这些离散变量中的信息重构 (Reconstruct) 出来。

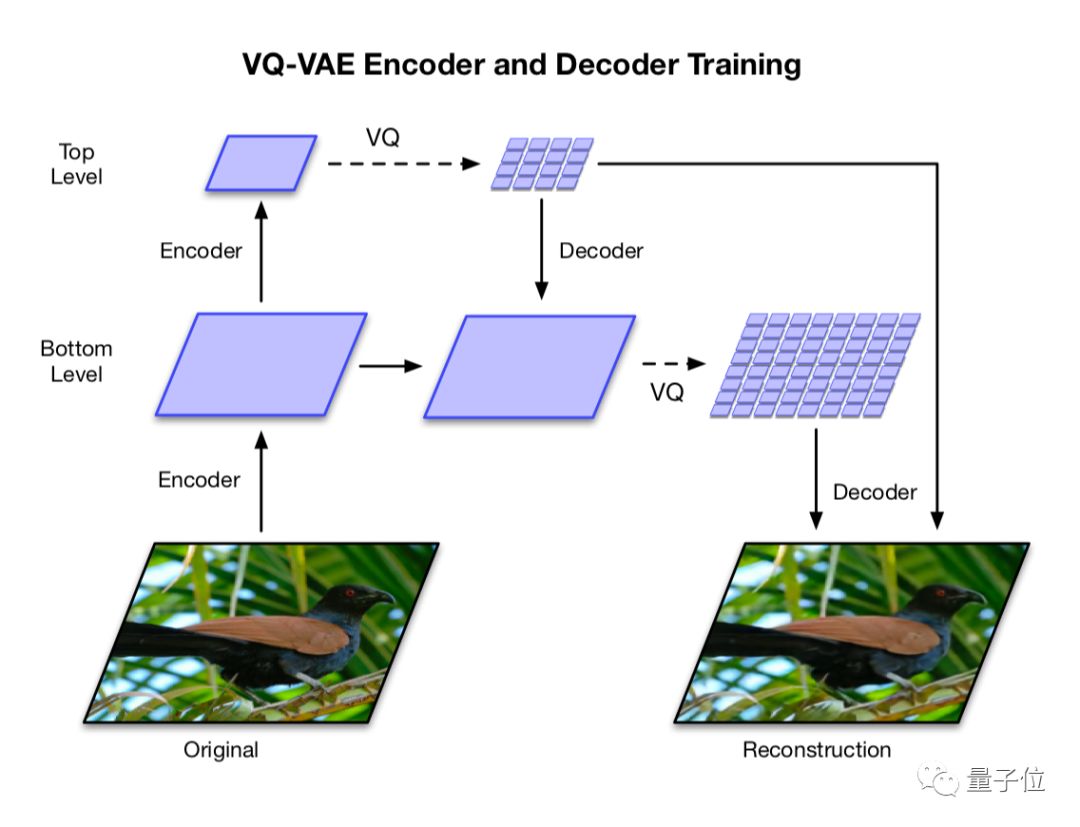

系统分成两部分,都是由编码器和解码器构成的。

第一部分

它是一个分层的VQ-VAE,可以把不同尺度的信息分开处理。

比如,输入一张256×256图像,编码器要把它压缩进不同的潜在空间里:

顶层 (Top Level) 要压缩成64×64的潜在映射图,为**全局信息 (比如形状等) 生成潜码;

底层 (Bottom Level) 要压缩成32×32的潜在映射图,为局部信息(比如纹理等) 生成潜码。

然后,解码器用这两个潜在映射图 (Latent Maps) 中,做出一张与原图同样大小的重构图,其中包含了局部和全局信息。

团队发现,如果不用顶层来调节 (Condition) 底层,顶层就需要编码像素中每一个细节。

所以,他们就让每个层级分别依赖于像素 (Separately Depend on Pixels) :可以鼓励AI在每个映射图中,编码补充信息 (Complementary Information) ,降低重构误差。

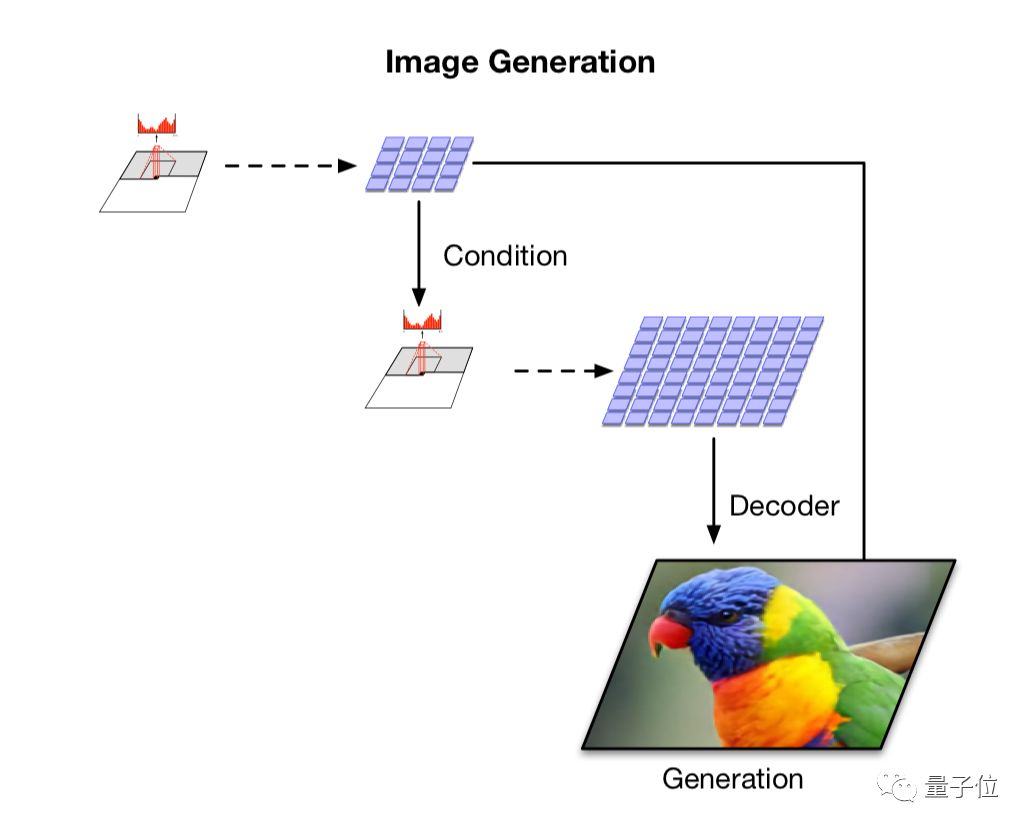

而学到分层潜码(Hierarchical Latent Codes) 之后,该进入下一部分了:

第二部分

在从潜码中学到先验(Prior) ,生成新图。

这一部分,是二代与一代最大的区别所在:把一代用到的自回归先验 (Autoregressive Priors) 扩展、增强了。

用当前最优秀的PixelRNN模型来为先验建模,这是一个带自注意力机制的自回归模型,能够把先验分布 (Prior Distribution) ,和上一部分学到的边界后验 (Marginal Posterior) 匹配起来。

这样,可以生成比从前相干性更高,保真度也更高的图像。

和第一部分相似:这里也有编码器和解码器,可以进一步压缩图像。

做好之后,从先验里取样,可以生成新的图像:和原图清晰度一致,并且保持了相关性 (Coherence) 。

两个部分合在一起,可以把256×256的图像,压缩200倍来学习;把1024×1024的高清大图,压缩50倍来学习。

团队说这样一来,把图像生成速度提升了一个数量级。

在需要快速编码、快速解码的应用上,这样的方法便有了得天独厚的优势。

同时,还避免了GAN的两个著名缺点:

一是mode collapse,即生成某些图像之后,GAN的生成器和判别器就达成和解,不再继续学习了;二是多样性不足的问题。

作者简介

这项研究的作者共有三位,均来自DeepMind,Ali Razavi和Aäron van den Oord为共同一作,Oriol Vinyals为二作。

Ali Razavi博士毕业于滑铁卢大学,此前在IBM、Algorithmics和Google就职过,2017年加入DeepMind,任职研究工程师。

研究员Aäron van den Oord小哥主要研究生成模型,此前还参与Google Play的音乐推荐项目。

2017年,Aäron参与了哈萨比斯项目组关于Parallel WaveNet的研究,为这篇论文的第一作者。

Oriol Vinyals小哥此前参与了多个明星项目,比如星际项目、比如AlphaStar,还与图灵奖得主Geoffrey Hinton和谷歌大脑负责人Jeff Dean一起合作过,合著论文Distilling the knowledge in a neural network。

对了,最先称赞BigGAN是“史上最佳GAN”的人,也是他~

传送门

论文Generating Diverse High-Fidelity Images with VQ-VAE-2地址:

//p1-tt.byteimg.com/origin/pgc-image/RSYeEjy1ZpBM1F.jpg" style="width: 650px;">

VQ-VAE 这种模型在生成真实高清样本时,它能捕捉数据集中展示的多样性。这种多样性可能体现在年龄、性别、肤色和发色等特征上,这些是 BigGAN 很难显式捕捉到的。如下展示了 VQ-VAE 在 FFHQ-1024 高清数据集上训练后的生成效果,细节都非常合理:

那么 VQ-VAE 和 BigGAN 的直观对比是什么样的?如下左边 16 张图为 VQ-VAE 的生成效果,右边 16 张为 BigGAN 的生成效果。它们都是根据 ImageNet 中的同一类别生成的,但我们会发现 VQ-VAE 不仅在多样性上非常强,在生成细节上也非常厉害。BigGAN 生成的人脸并不是太自然,五官错位有些严重。

深度生成模型都有什么问题

研究者将常见的生成模型分为两种:一种是基于似然的模型,包括 VAE 及其变体、基于流的模型、以及自回归(autoregressive)模型,另一种是隐式生成模型,如生成对抗网络(GAN)。这些模型都会存在某些方面的缺陷,如样本质量、多样性、生成速度等。

GAN 利用生成器和判别器来优化 minimax 目标函数,前者通过将随机噪声映射到图像空间来生成图像,后者通过分辨生成器生成的图像是否为真来定义生成器的损失函数。大规模的 GAN 模型已经可以生成高质量和高清晰度的图片。然而,众所周知,GAN 生成的样本并不能完全捕捉真实分布中的多样性。另一方面,针对生成对抗网络的评价非常困难,目前依然不存在一个较通用的度量标准,用于在测试集中判断模型是否过拟合。

与生成对抗网络不同的是,基于似然的模型在训练集上优化一个负对数似然函数(negative log-likelihood)。这一目标函数可以对模型进行对比并度量在未见数据上的泛化能力。此外,由于模型在训练集上对所有样本分配的概率都达到最大,理论上基于似然的模型可以覆盖数据的所有模式,不存在像生成对抗网络那样的模式崩塌(mode collapse)和多样性缺失(lack of diversity)问题。

但是在这些优点之外,直接最大化像素空间的似然是困难的。首先,像素空间上的负对数似然不一定是对生成样本质量的良好评估方式;其次对于这些模型而言,它们不一定会关注图像的全局结构,因此生成效果也不是很好。

「最强非 GAN 生成器」

在这篇论文中,研究者们利用了有损压缩的思想,令生成模型可以忽略对不重要信息的建模。事实上,JPEG 等图像压缩技术已经表明,在不对图像质量产生显著影响的情况下,我们可以移除超过 80% 以上的数据。正如以前研究所提出的,我们能将图像压缩到离散隐变量空间,这只需要通过自编码器的中间表征就能完成,即一种经量化的向量。

这些中间表征要比原始图像小三十多倍,但仍然能解码并重建为极其逼真的图像。这些离散表征的先验知识能利用当前最优的 PixelCNN(带自注意力机制)建模,其可以称为 PixelSnail。当模型从这些先验中采样时,解码的图像也会展现出高质量与重建的一致性。

图 1:带类别约束的图像生成样本(256x256),它们通过 ImageNet 上训练的两阶段模型可以生成逼真且一致的图像。

除了逼真以外,该生成模型在离散空间上的训练和采样也非常快,它比以前直接在像素空间运算要快 30 倍,这也就意味着能训练更高分辨率的图像。最后,该研究中的编码器和解码器都保留了原始 VQ-VAE 的简单性与速度,这意味着这种方法对于需要快速、低开销的大图编码、解码过程具有很大的吸引力。

生成图像两步走

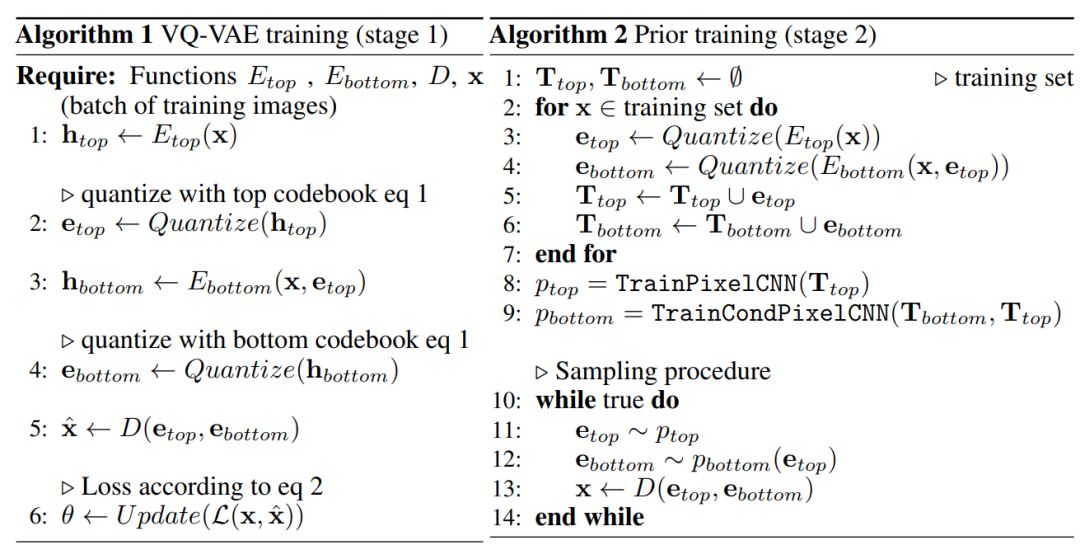

具体而言,提出的方法遵循两阶段过程:首先我们需要训练一个分层的 VQ-VAE,我们需要用它将图像编码到离散的隐空间;其次我们需要在离散的隐空间拟合一个强大的 PixelCNN 先验,这个隐空间是通过所有图像数据构建的。

如上算法 1 和算法 2 为两阶段过程,其中在第一阶段学习层次化隐编码中,我们可以借助层次结构建模大图像。其主要思想即将局部信息(例如纹理)与目标的几何形状等全局信息分开建模。在第二阶段中,为了进一步压缩图像,并且能够从第一阶段学习到的模型中采样,我们需要在隐编码中学习一种先验知识。

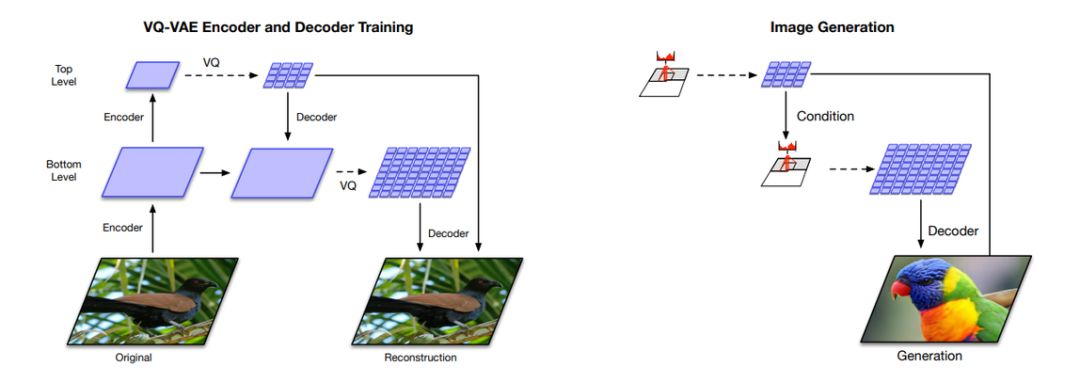

下图展示了该模型的训练和生成过程,它们的过程基本和自编码器类似。如下左图所示为分层 VQ-VAE 的整体架构,它是由编码器和解码器组成的深度神经网络。模型输入是一张 256×256 的图像,它会分别压缩为 64×64 的底层量化隐层和 32×32 的高层量化隐层。解码器从两个隐层中重建图像。

下图右侧为多阶段图像生成。高层 PixcelCNN 先验会通过类别标签进行约束,底层的 PixcelCNN 会以类别标签和第一级编码作为约束。由于前馈解码器的存在,隐层向像素的映射速度很快。(图 1 中的鹦鹉就是根据这个模型生成的)

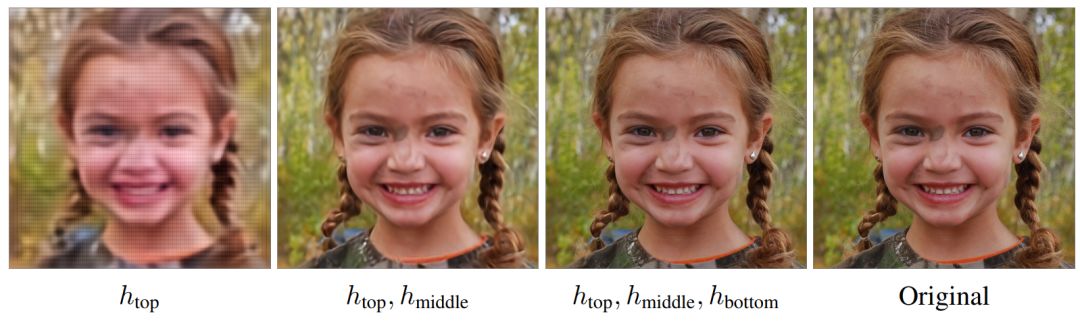

当然我们也可以用更多的层级来生成更清晰的大图。如下所示为利用不同层级编码所生成的图像结果。

图 3:从多层 VQ-VAE 的三种隐层中重建图像。最右边的是原图。对于每一个隐层,都会在重建中增加额外的细节。这些隐层的尺寸大约比原图分别小 3072x,768x,192x 倍。

实验

实验部分展示了模型在 ImageNet 256 × 256 上训练得到的定性和定量结果。从图 5 中的类别条件样本中可以看出,多个代表性类的样本质量确实非常高。在多样性方面,研究者提供了可以与 BigGAN-deep(当前的 SOTA GAN 模型)相媲美的模型样本(如图 5 所示)。从这些对照比较中可以看出,VQ-VAE 可以生成媲美 GAN 保真度的样本,但多样性更高。

图 5:本文提到的方法与 BigGAN Deep 模型在生成样本多样性方面的比较。我们会发现即使在 BigGAN 拥有最大多样性的情况下,VQ-VAE 生成图像的多样性也要显著多一些。如果读者放大原论文中的原图,就会发现更多的生成细节。

建模高分辨率人脸图像

为了进一步评估文中方法在获取数据中超长依赖方面的有效性,研究者在分辨率为 1024 × 1024 的 FFHQ 数据集上训练了一个三级分层模型。

图 6:在 FFHQ-1024 × 1024 数据集上训练得到的三级分层模型中的代表性样本。该模型可以生成逼真的人脸,这些人脸符合长距离依赖,如匹配眼睛颜色或对称的人脸特征,同时还覆盖了数据集中的低密度模式(如绿色头发)。

定量评估

本实验中的定量评估旨在度量生成样本的质量和多样性。

负对数似然和重建误差

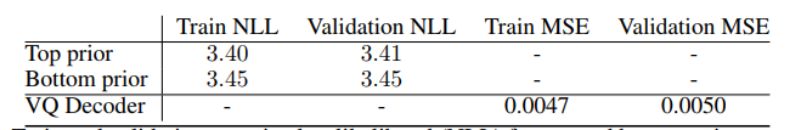

表 1 为文中模型 top 先验和 bottom 先验的 NLL 值,在训练和验证方面都很接近,表示两个网络都没有过拟合。

表 1:top 先验和 bottom 先验设定下训练和验证的夫多数似然与均方误差值。

精度-召回率(recall)度量

图 7b:利用精度/召回率度量对多样性—质量权衡进行定量评估

分类准确度分数(CAS)

研究者还利用最近提出的分类准确率分数(CAS)对他们的方法进行评估,这只需要在候选模型的样本上训练一个 ImageNet 分类器即可,但还要评估该分类器在测试集真实图像中的分类准确度,这样就可以衡量样本质量和多样性。利用 CAS 度量的评估结果如下表所示:

表 2:真实数据集、BigGAN-deep 和 VQ-VAE 模型的分类准确率分数(CAS)

1.FID 和 Inception 分数(IS)

图 7a:利用 FID 和 IS 对多样性—质量权衡进行定量评估

版权声明:CosMeDna所有作品(图文、音视频)均由用户自行上传分享,仅供网友学习交流。若您的权利被侵害,请联系删除!

本文链接://www.cosmedna.com/article/642194263.html